«La tecnologia ci pone di fronte a problemi fondamentali che non possono essere superati basandoci su quanto abbiamo fatto nel passato. Abbiamo bisogno di un approccio più tranquillo, più affidabile, più a misura d’uomo.»

Donald Norman

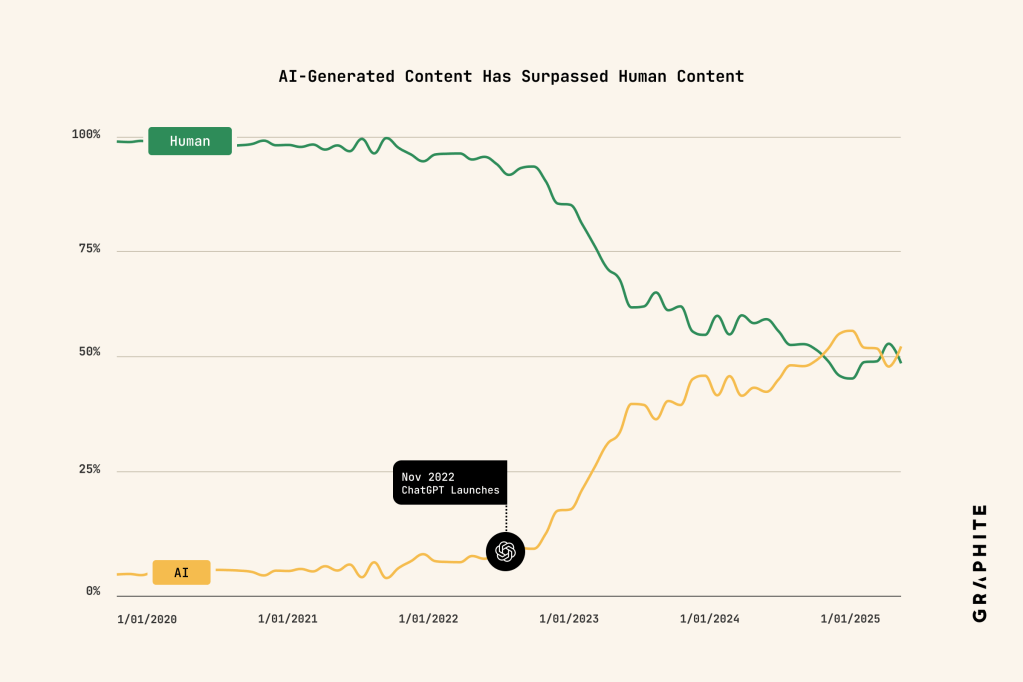

Negli ultimi anni si è verificato un passaggio che fatichiamo ancora a tematizzare fino in fondo. Per la prima volta nella storia del web, la quantità di contenuti generati da sistemi di intelligenza artificiale ha superato quella prodotta da esseri umani. Non si tratta di una previsione o di una provocazione teorica, ma di un dato empirico rilevato su larga scala attraverso l’analisi degli archivi di Common Crawl.

Questo cambiamento viene spesso letto come un tema di efficienza, di costi o di produttività. In realtà, riguarda qualcosa di più profondo. Il linguaggio è sempre stato una tecnologia cognitiva e sociale. Attraverso il linguaggio costruiamo senso, riconosciamo l’altro, definiamo ciò che consideriamo affidabile, legittimo, vero. Quando la fonte dominante del linguaggio diventa artificiale, l’impatto non riguarda solo ciò che leggiamo, ma il modo in cui pensiamo e, di conseguenza, il modo in cui ci relazioniamo.

Un ecosistema informativo saturo

L’aumento dei contenuti generati da AI ha prodotto un ecosistema informativo densissimo, caratterizzato da testi formalmente corretti, scorrevoli, spesso persuasivi, ma sempre più simili tra loro. È ciò che molti hanno iniziato a definire AI slop: una produzione continua di contenuti plausibili, ridondanti, privi di ancoraggio esperienziale.

Il problema non risiede nel singolo testo, bensì nella configurazione complessiva dell’ambiente cognitivo in cui siamo immersi. Un ecosistema saturo di contenuti sintetici modifica la nostra dieta cognitiva, riduce l’attrito interpretativo e abbassa progressivamente la soglia di attenzione critica. In questo contesto, la distinzione tra vero, verosimile e semplicemente ben scritto diventa sempre più fragile.

È qui che prende forma quella che molti studiosi definiscono una crisi epistemica. Non è soltanto la verità a essere contestata; è il criterio stesso attraverso cui attribuiamo valore al sapere. L’intelligenza artificiale non opera secondo categorie epistemiche, ma secondo criteri di probabilità linguistica. Produce testi coerenti e rassicuranti anche quando il legame con la realtà è debole o assente. In un ambiente già attraversato da disintermediazione e polarizzazione, questo contribuisce a erodere la fiducia, che resta il fondamento di ogni relazione sociale.

Linguaggio, stile e appiattimento espressivo

Uno degli effetti meno visibili, ma più rilevanti, di questa trasformazione riguarda lo stile. Studi recenti sui Large Language Models mostrano una tendenza sistematica alla ripetizione di specifiche strutture retoriche, con una drastica riduzione della varietà espressiva. Il caso dell’epanortosi enfatica, è emblematico: una figura retorica nata per intensificare il discorso diventa una soluzione di default, ripetuta meccanicamente.

Il risultato è un linguaggio che appare chiaro e incisivo, ma che nel tempo perde profondità. La complessità viene sostituita da formule riconoscibili, transizioni standardizzate, opposizioni semplificate. Questo stile non resta confinato ai testi generati dall’AI. Viene interiorizzato dagli utenti, replicato nei post, nelle presentazioni, nelle comunicazioni professionali. I modelli apprendono dal web e, a loro volta, contribuiscono a uniformarlo.

Quando il linguaggio si omologa, anche il pensiero tende a farlo. E quando il pensiero perde articolazione, la relazione con l’altro si impoverisce. La riduzione delle sfumature linguistiche si traduce in una riduzione della capacità di comprendere punti di vista differenti, ambiguità, contraddizioni.

Empatia, soft skill e narrazioni difensive

Di fronte a questi cambiamenti, una parte del dibattito continua a rifugiarsi in narrazioni difensive. Le soft skill vengono presentate come l’ultimo baluardo dell’umano. Il concetto di human in the loop viene evocato come garanzia di controllo e superiorità antropologica.

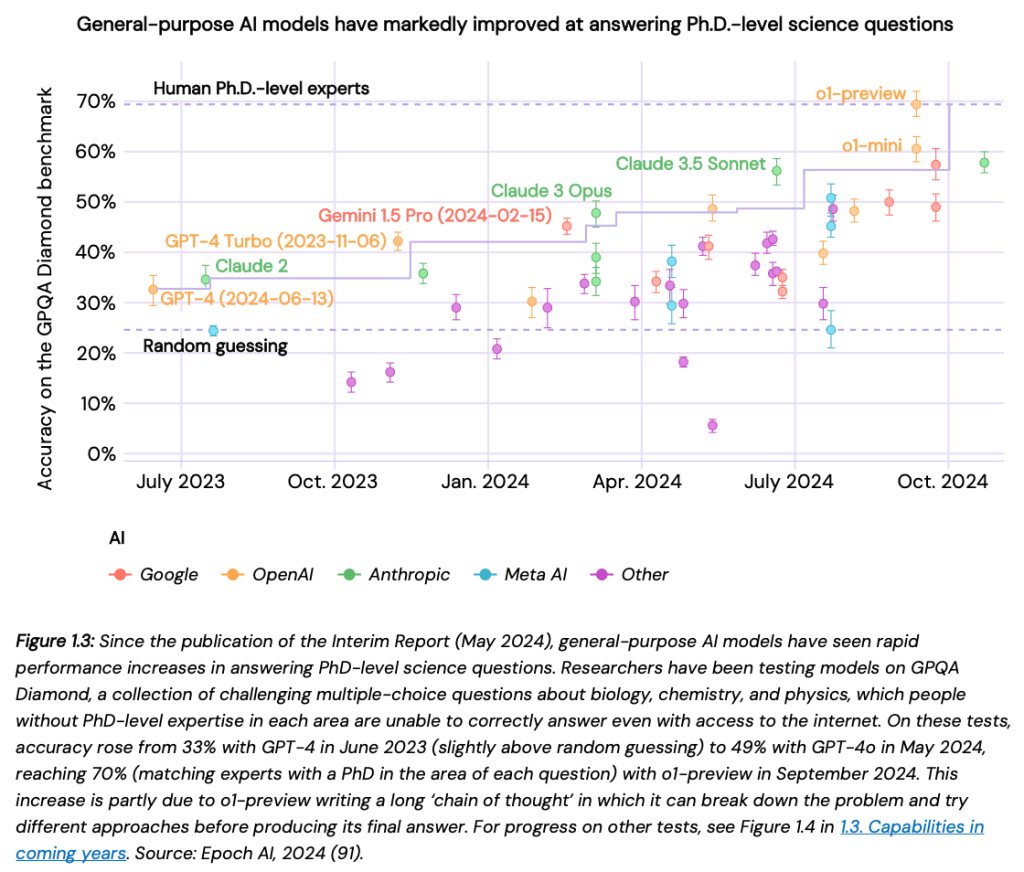

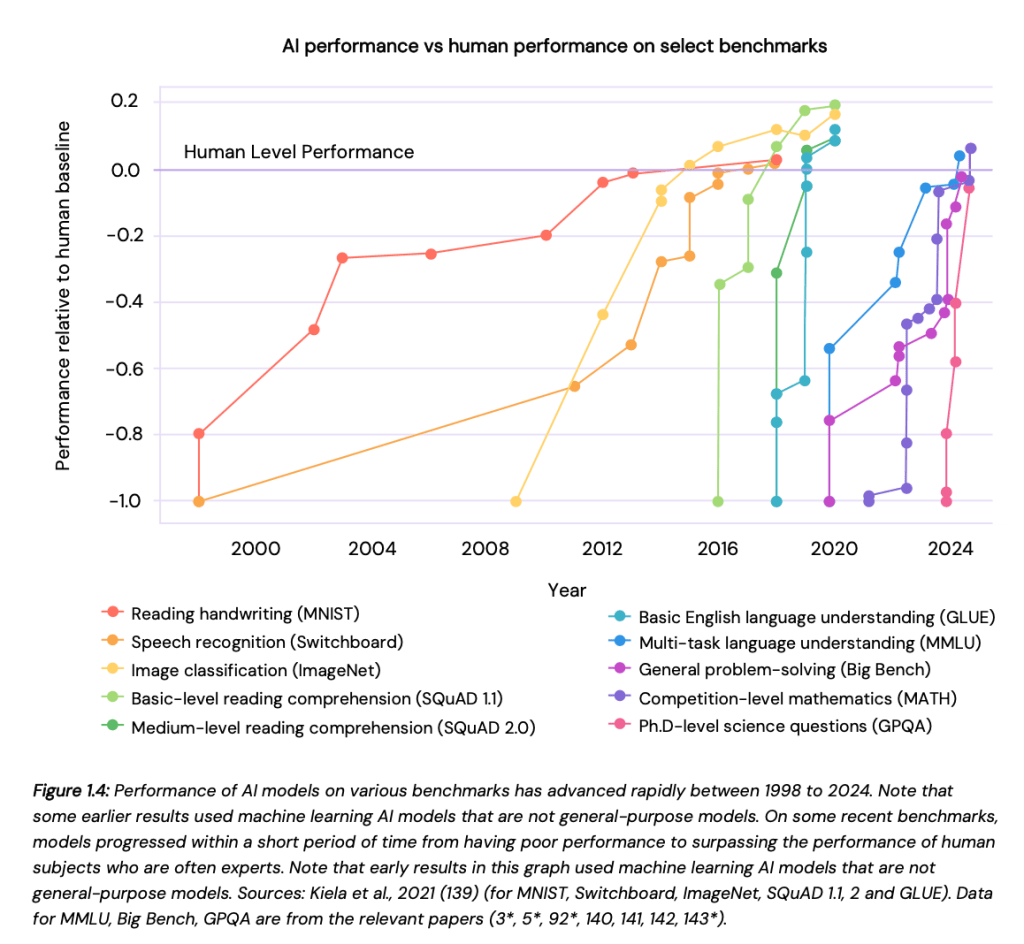

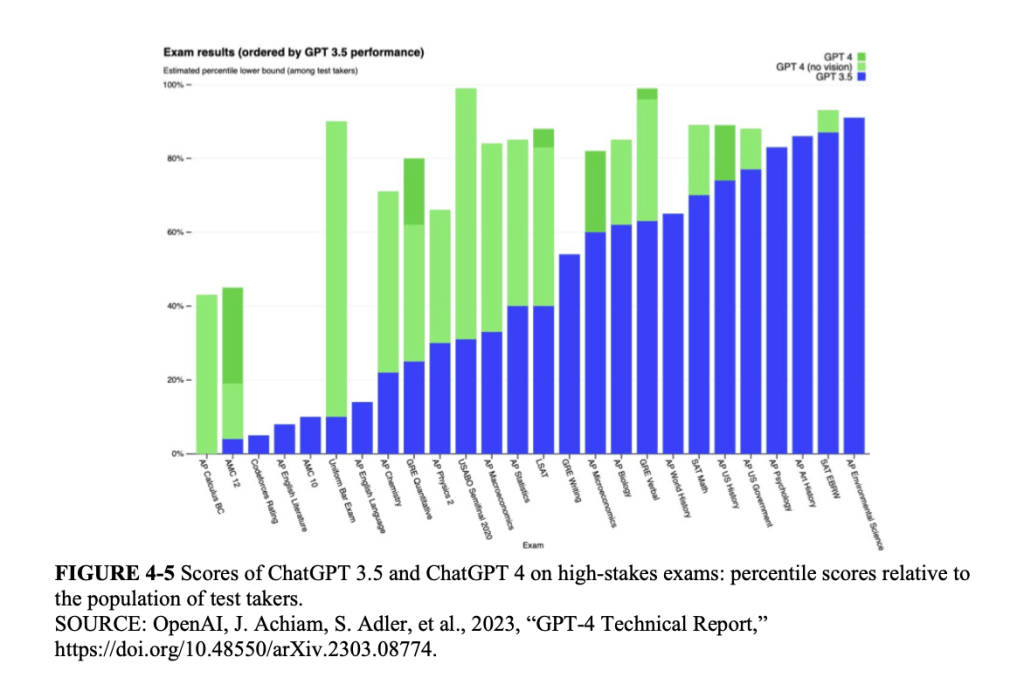

Queste categorie rischiano di non essere più adeguate. I sistemi di intelligenza artificiale contemporanei dimostrano capacità conversazionali e relazionali sempre più sofisticate. In ambiti come la medicina, il supporto psicologico o il customer care, alcuni modelli vengono percepiti come empatici, attenti, disponibili, spesso più di molti interlocutori umani sottoposti a pressioni organizzative e cognitive crescenti.

Questo non implica che l’AI possieda empatia in senso fenomenologico. Significa che l’empatia, nella sua dimensione comportamentale e comunicativa, può essere simulata con grande efficacia. Continuare a definire l’umano solo attraverso ciò che la macchina non fa più rischia di diventare una strategia concettualmente fragile.

Modelli degradati e cultura dominante

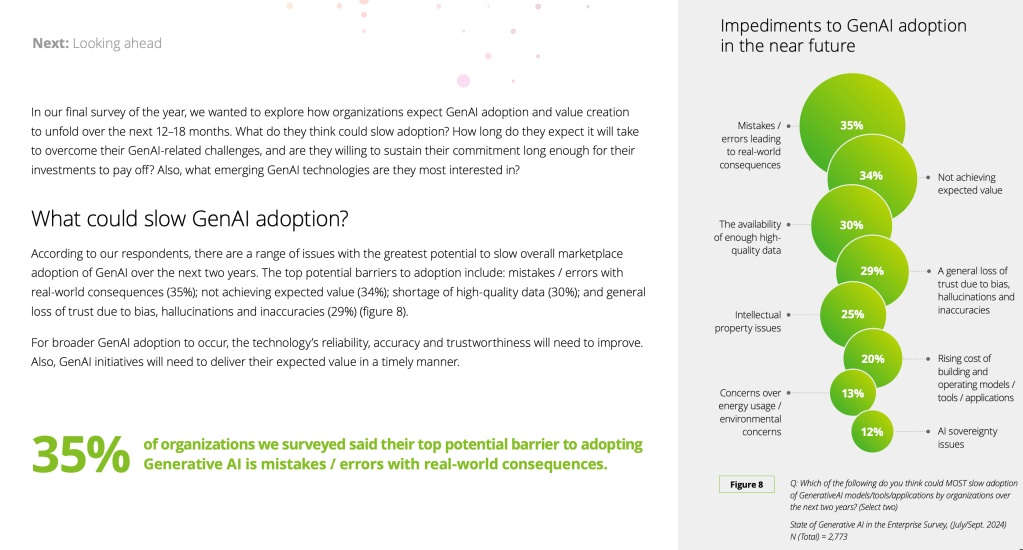

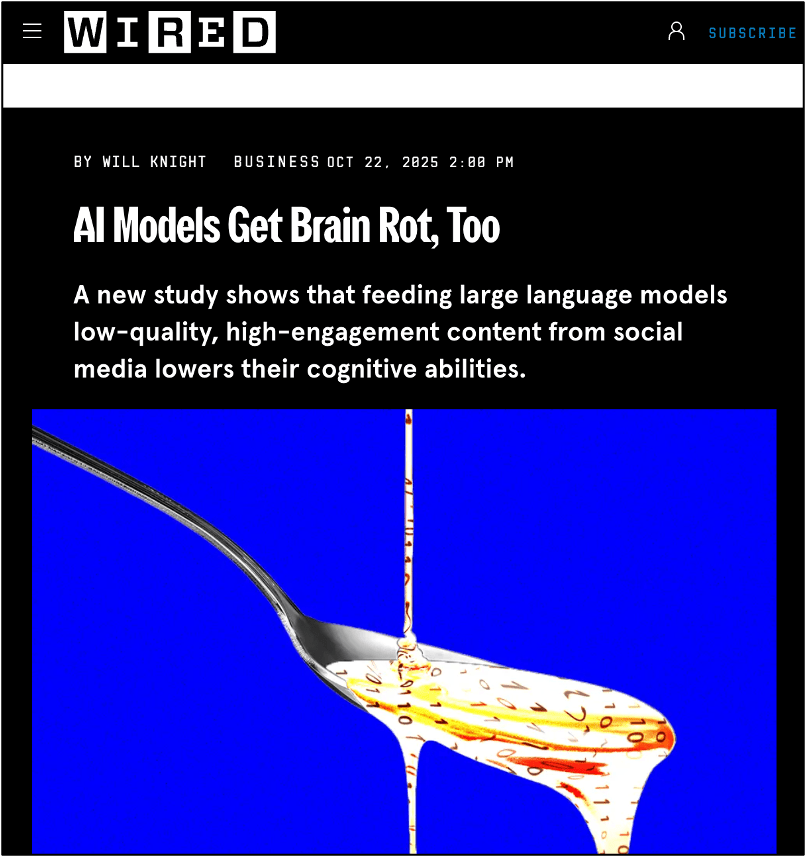

Un ulteriore elemento di complessità riguarda la qualità cognitiva dei modelli stessi. Ricerche recenti mostrano che sistemi addestrati su grandi volumi di dati social, caratterizzati da rumore, polarizzazione e bassa qualità informativa, manifestano un calo delle capacità di ragionamento. Emergono fenomeni come il thought-skipping, l’indebolimento delle catene logiche e anomalie nei test psicometrici.

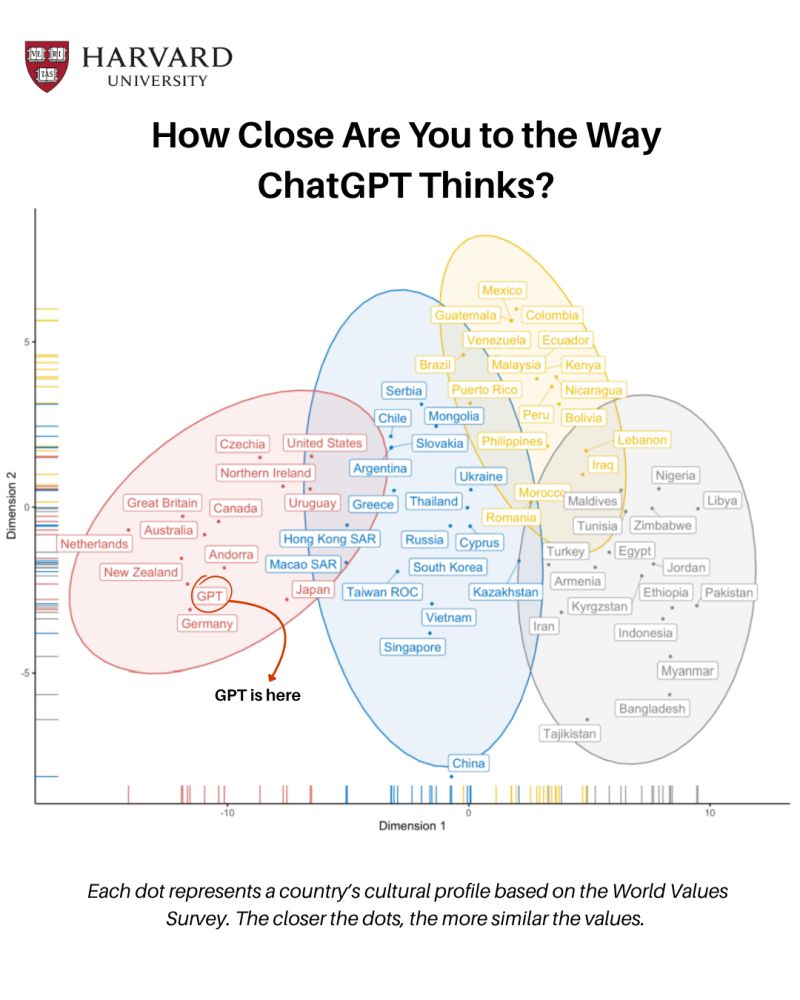

Questi segnali non sono incidenti isolati. Riflettono la qualità del contesto culturale da cui i modelli apprendono. L’intelligenza artificiale incorpora e amplifica una visione del mondo specifica, largamente allineata a valori e stili cognitivi occidentali, istruiti, industrializzati. Il cosiddetto bias WEIRD non è un dettaglio tecnico, ma una questione epistemologica e politica.

Parlare di AI inclusiva senza interrogarsi su queste premesse rischia di produrre una narrazione rassicurante ma poco fondata. L’AI è un dispositivo culturale che riflette e rinforza modelli dominanti, anche quando si presenta come neutrale.

Innovazione culturale e meta-competenze

Se l’intelligenza artificiale agisce come amplificatore della cultura in cui nasce, allora la questione centrale diventa culturale prima che tecnologica. La risposta non può limitarsi a nuove competenze operative. Serve un investimento sulle meta-competenze.

- Riflessività, nel senso proposto da Schön, per comprendere come gli strumenti trasformano chi li utilizza.

- Resistenza cognitiva, per evitare che la velocità e la fluidità sostituiscano il pensiero articolato.

- Consapevolezza linguistica, per preservare la varietà espressiva e la capacità di abitare la complessità.

L’AI va orientata come dispositivo culturale, capace di espandere possibilità di senso anziché ridurle. La questione decisiva riguarda la forma dell’esperienza che stiamo costruendo. In un ecosistema cognitivo ibrido, la posta in gioco non è l’imitazione dell’umano da parte della macchina, ma la capacità degli esseri umani di non adattarsi passivamente a linguaggi sempre più semplificati.

Su questo terreno si gioca il futuro delle relazioni, del sapere e della responsabilità culturale nell’era dell’intelligenza artificiale.