“Le domande come ‘che cos’è l’intelligenza artificiale?’ o ‘è possibile?’ non hanno più senso. Ciò che conta ora sono le questioni aperte sulla sua natura e il suo impatto.”

— Daniel C. Dennett

Una nuova svolta antropologica

L’Intelligenza Artificiale (AI) non rappresenta semplicemente un’evoluzione tecnologica: è la più profonda provocazione antropologica che l’umanità abbia mai affrontato. Come sottolinea Dennett, non ha più senso chiedersi se l’AI sia possibile; la vera domanda è come essa stia cambiando la nostra condizione umana.

L’AI sta già ridefinendo non solo i meccanismi del lavoro, ma anche i dispositivi interpretativi attraverso i quali costruiamo senso, comunichiamo significati, comprendiamo il mondo. Una trasformazione che richiama la profonda connessione fra tecnologia e cognizione umana studiata da Doreen Kimura, che ha mostrato la relazione fra le aree cerebrali deputate ai movimenti fini e quelle del linguaggio, evidenziando come l’evoluzione della manipolazione tecnica sia legata a quella della capacità di articolare concetti complessi.

Non è un caso, allora, che i Large Language Models (LLM) rappresentino ben più di un salto tecnico: essi riscrivono il modo in cui generiamo, manipoliamo e condividiamo significato. Il linguaggio da dispositivo interpretativo si fa sintetico, generativo, artificiale—sfidando i confini tra naturale e artificiale.

Lo stesso accade con le immagini: la fotografia, un tempo specchio del reale, ora genera mondi mai esistiti. La catena referenziale della verità si spezza, aprendo a nuove ambiguità, creatività—e rischi.

L’AI ci obbliga dunque a ripensare le frontiere fra naturale e artificiale, conoscenza e calcolo, delega e responsabilità. Come afferma Manuel Castells, non c’è rivoluzione tecnologica senza rivoluzione culturale.

Come restare rilevanti in questo scenario? Come rafforzare le competenze umane distintive quando le macchine ci superano nei compiti che consideravamo unici? La sfida che si pone a HR, formatori, leader non è tecnica, ma culturale.

Serve uno sguardo integrato, che intrecci dimensioni storiche, filosofiche, sociologiche, cognitive, per orientare la trasformazione del lavoro e delle organizzazioni.

Il continuum evolutivo della tecnica

L’AI non è una rottura improvvisa nella storia umana. Come osservava Ernst Mach nel 1905, l’uomo è spinto da una naturale inclinazione a riprodurre ciò che comprende—una tendenza che attraversa ogni epoca.

Dal mito di Prometeo ai calcolatori di Pascal, dagli automi greci ai sistemi AI odierni: è questo impulso a imitare e riprodurre il reale a generare evoluzione tecnologica. L’AI ne è l’espressione più radicale.

Per Arnold Gehlen, l’uomo è un essere biologicamente incompleto, che esternalizza funzioni vitali in strumenti e ambienti. La tecnologia non è un accessorio: è estensione funzionale dell’umano. L’AI è oggi la più avanzata protesi epistemologica, che ridefinisce percezione, decisione, apprendimento.

Il Test di Turing (1950) ha spostato la questione dal meccanico all’identitario: se una macchina si comporta come un uomo, dov’è il confine della coscienza? Penrose, Churchland, Barr & Feigenbaum, Edelman hanno spinto più a fondo il dibattito, intrecciando filosofia, neuroscienze, cibernetica.

Le macchine Darwin III e Nomad di Edelman hanno mostrato come l’apprendimento possa emergere dall’adattamento, non dalla programmazione. Allo stesso modo, gli agenti intelligenti descritti da Giuseppe Riva rivelano l’AI come nuovo attore cognitivo nello spazio umano.

L’AI riflette così le nostre aspirazioni, contraddizioni, paure. È prisma della tensione evolutiva fra conoscenza e calcolo, intuizione e automatismo, creatività e replica.

Riflessività e resistenza: vantaggi cognitivi umani

Per questo il ruolo umano nella governance dell’AI deve cambiare. Come scrive Donald Schön, i professionisti efficaci agiscono in “zone indeterminate” — spazi di incertezza e conflitto. Qui conta la reflection-in-action: la capacità di percepire, interrogare, modificare in corso d’opera.

Per le organizzazioni ciò significa trattare l’adozione dell’AI come processo adattivo continuo, non come progetto tecnico finito. Serve chiedersi: quali effetti imprevisti produce? Come cambiano dinamiche di team, potere, competenze?

La reflection-on-action amplia questo lavoro: rileggere pratiche, assunzioni, risultati; promuovere cultura del feedback, policy trasparenti, apprendimento permanente.

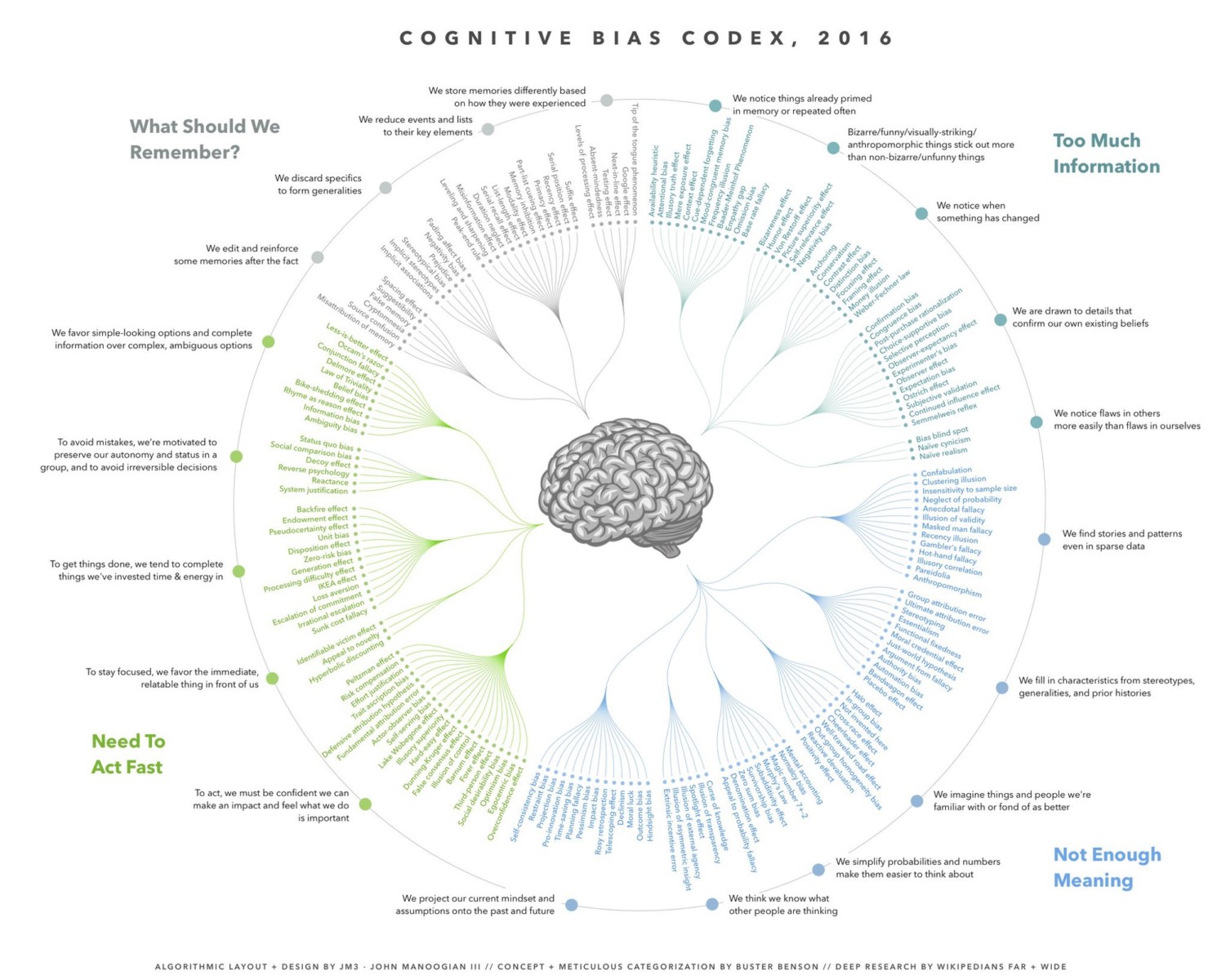

Essenziale anche il concetto di Olivier Houdé di “imparare a resistere“. Nell’era degli LLM, resistere alla risposta immediata e intuitiva diventa competenza cruciale. L’output dell’AI può sembrare autorevole—ma richiede verifica, controllo delle fonti, giudizio critico.

Questa resistenza cognitiva tutela l’unicità umana: creatività, empatia, etica, analisi critica. Senza di essa rischiamo di ridurci a validatori passivi di decisioni algoritmiche.

Dall’Human-in-the-Loop all’Human-on-the-Loop

Serve allora un salto di paradigma: da “human-in-the-loop” a “human-on-the-loop”.

L’”in-the-loop” confina l’umano a supervisore di emergenza, ruolo reattivo e marginale. L’”on-the-loop” vede l’umano come progettista, stratega, governatore del sistema:

- Definizione di scopo e limiti;

- Progettazione di architetture etiche e trasparenti;

- Interpretazione dei risultati nel contesto socio-culturale;

- Controllo ultimo e potere di disattivazione.

HR ha qui ruolo cruciale: l’AI impatta reclutamento, formazione, collaborazione, valutazione, cultura. Il compito è garantire che essa amplifichi—non impoverisca—potenziale, diversità, autonomia umana.

Implicazioni organizzative: strategia, competenze, etica

- Strategia: integrazione AI richiede adattamento culturale e strutturale, non solo tecnico.

- Competenze: l’OCSE avverte sul divario di skill. Urgente riqualificazione diffusa.

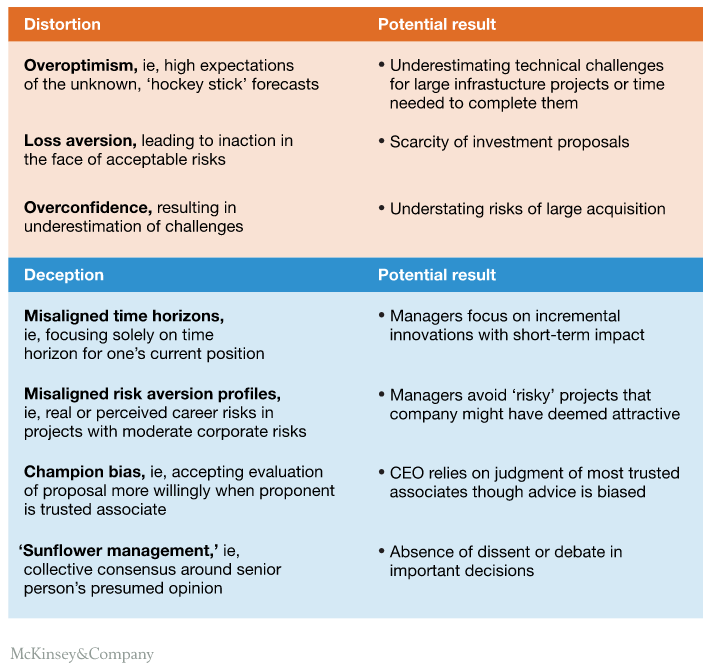

- Governance: come indicano Deloitte e McKinsey, le aziende sono impreparate alla gestione dei rischi AI. Servono policy robuste.

- Cultura: l’AI ridefinisce l’identità organizzativa. HR deve gestire paure, resistenze, promuovere adozione consapevole.

- Etica: come nota Kurzweil, se le macchine imitano l’uomo, la posta etica si alza. L’agenzia umana responsabile resta insostituibile.

Verso un nuovo umanesimo digitale

L’AI ci impone di rinnovare competenze umanistiche: metacognizione, etica, riflessività, resistenza. Non sono lussi—sono competenze di sopravvivenza.

Come scriveva Antoine de Saint-Exupéry:

“La tecnologia non allontana l’uomo dai grandi problemi della natura: lo costringe a studiarli più a fondo.”

Dobbiamo accogliere questa sfida.

Letture consigliate e riferimenti bibliografici

- Accoto, C. (2017). Il mondo dato: Cinque brevi lezioni di filosofia digitale. Egea.

- Accoto, C. (2023). Il pianeta latente: L’intelligenza delle piattaforme come nuovo ordine del mondo. Egea.

- Besana, S. (2021). The Future of Work: AI, People, and Organizational Change. Hoepli.

- Castells, M. (1996). The rise of the network society. Blackwell.

- Churchland, P. M. (1984). Matter and consciousness: A contemporary introduction to the philosophy of mind. MIT Press.

- Deloitte. (2024–2025). Human Capital Trends 2024–2025. Deloitte Insights.

- Dennett, D. C. (1996). Kinds of minds: Toward an understanding of consciousness. Basic Books.

- Edelman, G. M. (1987). Neural Darwinism: The theory of neuronal group selection. Basic Books.

- Feigenbaum, E. A., & Barr, A. (1981). The handbook of artificial intelligence (Vol. 1). Heuristech Press.

- Gehlen, A. (1980). Man in the age of technology. Columbia University Press.

- Houdé, O. (2019). The psychology of intelligence. Routledge.

- Kurzweil, R. (1999). The age of spiritual machines: When computers exceed human intelligence. Penguin Books.

- Mach, E. (1905). The analysis of sensations (C. M. Williams, Trans.). Dover Publications.

- McKinsey & Company. (2023). The state of AI in 2023: Generative AI’s breakout year. McKinsey Global Survey.

- OECD. (2023). Skills Outlook 2023: Skills for a resilient green and digital transition. OECD Publishing.

- Penrose, R. (1989). The emperor’s new mind: Concerning computers, minds, and the laws of physics. Oxford University Press.

- Riva, G. (2004). The psychology of cyberspace: The impact of the Internet on self and society. Ios Press.

- Saint-Exupéry, A. de. (2000). Wind, sand and stars (L. Galantière, Trans.). Mariner Books. (Original work published 1939)

- Schön, D. A. (1983). The reflective practitioner: How professionals think in action. Basic Books.

- Turing, A. M. (1950). Computing machinery and intelligence. Mind, 59(236), 433–460.