Chi segue questo spazio – e in generale quello che scrivo ormai da quasi un ventennio – sa che il tema del futuro del lavoro non ha mai rappresentato, per me, una semplice etichetta editoriale, ma un campo di ricerca e di pratica nel quale convergono tecnologia, organizzazione, cultura e responsabilità manageriale. Nel 2022 pubblicavo Future of Work: le Persone al Centro, costruire il lavoro e la società del futuro.

Oggi quel lavoro torna in una nuova edizione, rivista, ampliata e aggiornata alla luce delle trasformazioni che, in questi anni, hanno ridefinito con forza il perimetro del possibile.

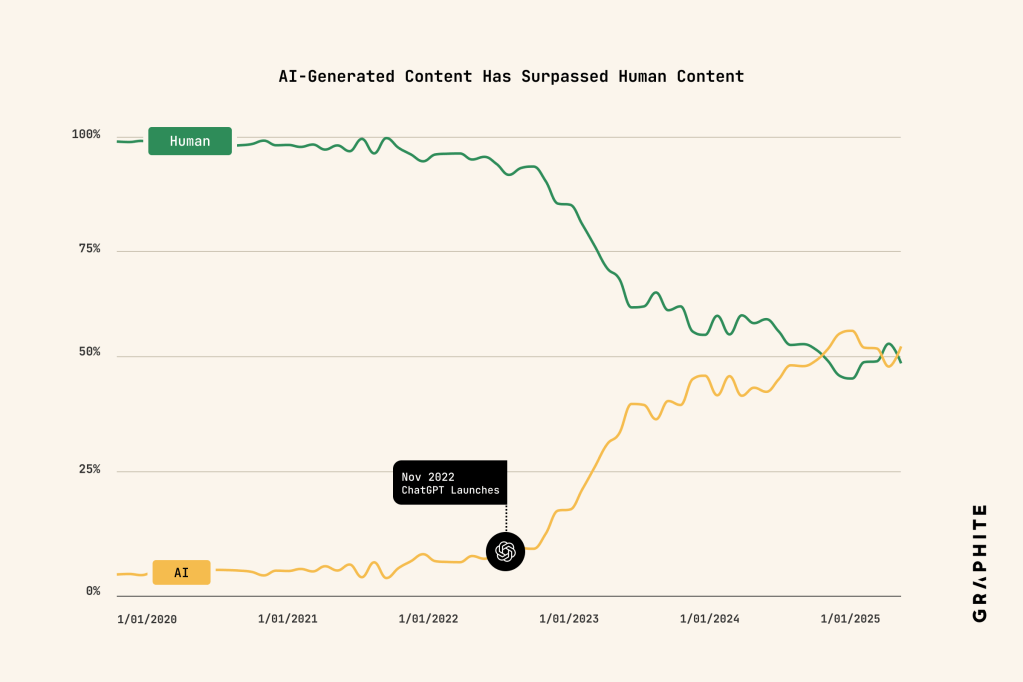

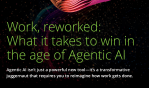

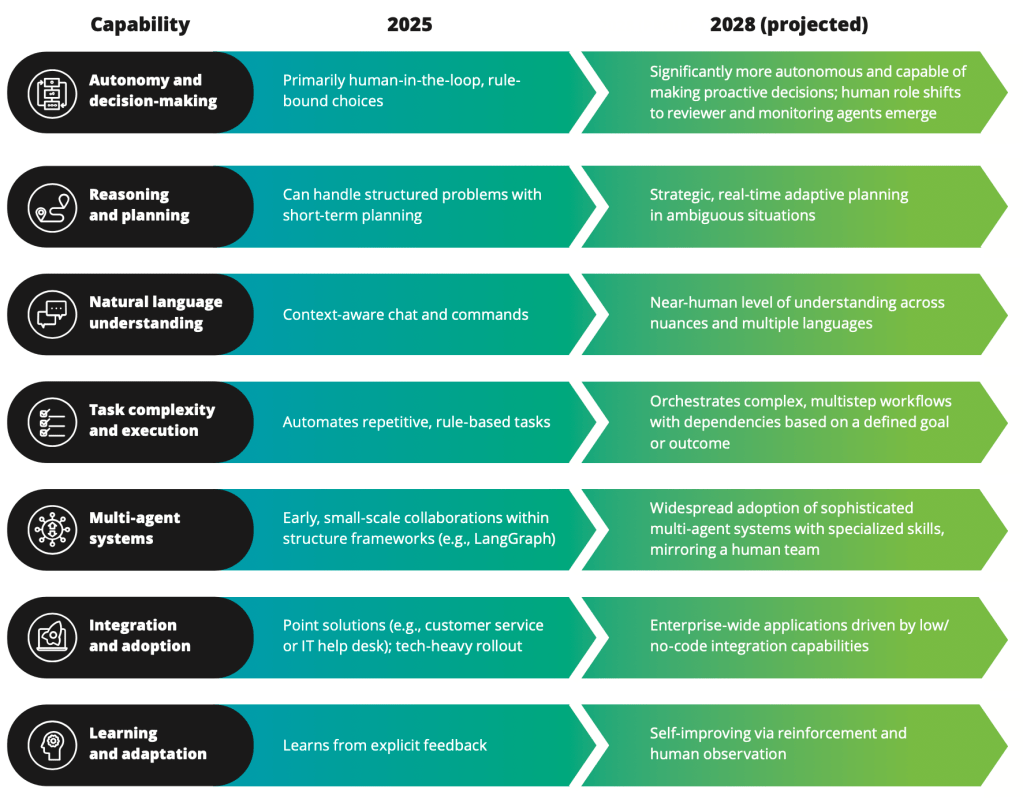

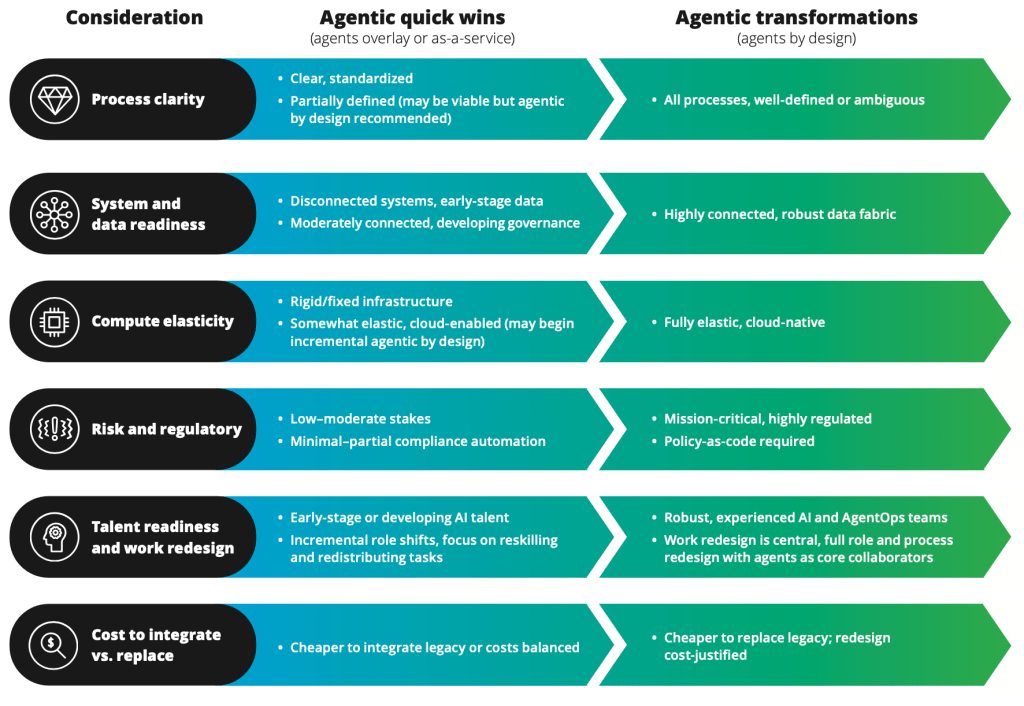

Viviamo una fase storica in cui la quantità di contenuti prodotti dall’intelligenza artificiale supera ormai quella generata dagli esseri umani. È un fenomeno organizzativo, culturale, antropologico, ancor prima che tecnologico. Impone una revisione profonda dei processi aziendali, dei modelli decisionali, delle architetture di governance e delle pratiche di collaborazione. Non si tratta di introdurre nuovi strumenti, ma di ripensare il modo in cui il valore viene generato, validato e distribuito all’interno delle organizzazioni.

Le imprese non possono limitarsi ad adattarsi in modo reattivo. È necessario assumere una postura diretta, consapevole, capace di dare indirizzo. Governare il cambiamento significa orientarlo, definire priorità, stabilire confini etici e criteri di responsabilità. Significa chiarire quale ruolo attribuire ai sistemi di AI nei processi critici, quali competenze sviluppare, quali rischi presidiare. La neutralità, in questa fase, non è un’opzione strategica.

Allo stesso tempo, la cooperazione uomo–macchina non è più un’ipotesi teorica. È un dato di fatto che attraversa la quotidianità operativa di molte organizzazioni; questo richiede di accompagnare le persone, di progettare nuove modalità di collaborazione (come quelle che sono descritte nei casi riportati all’interno del volume), di ridefinire responsabilità e metriche di performance.

La nuova edizione di Future of Work nasce da questa consapevolezza. I capitoli sono stati aggiornati e ampliati per affrontare in modo sistematico l’impatto dell’intelligenza artificiale generativa, dei sistemi agentici e delle nuove infrastrutture digitali sul lavoro, sulla leadership e sui modelli organizzativi. Il focus rimane sulle persone, ma con uno sguardo ancora più attento alle implicazioni concrete per HR, top management e policy maker.

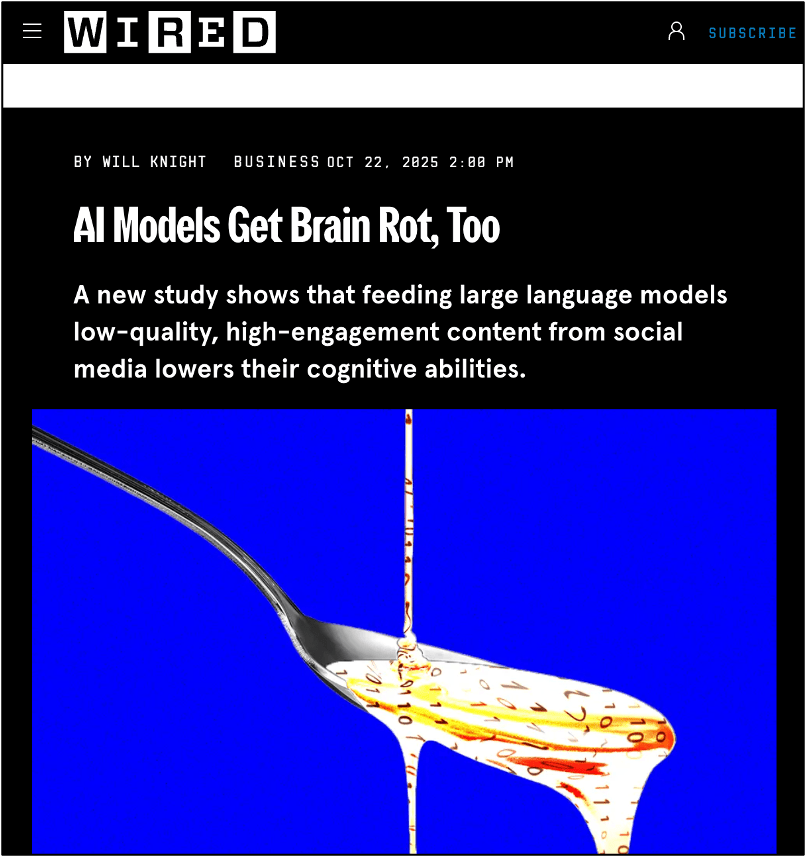

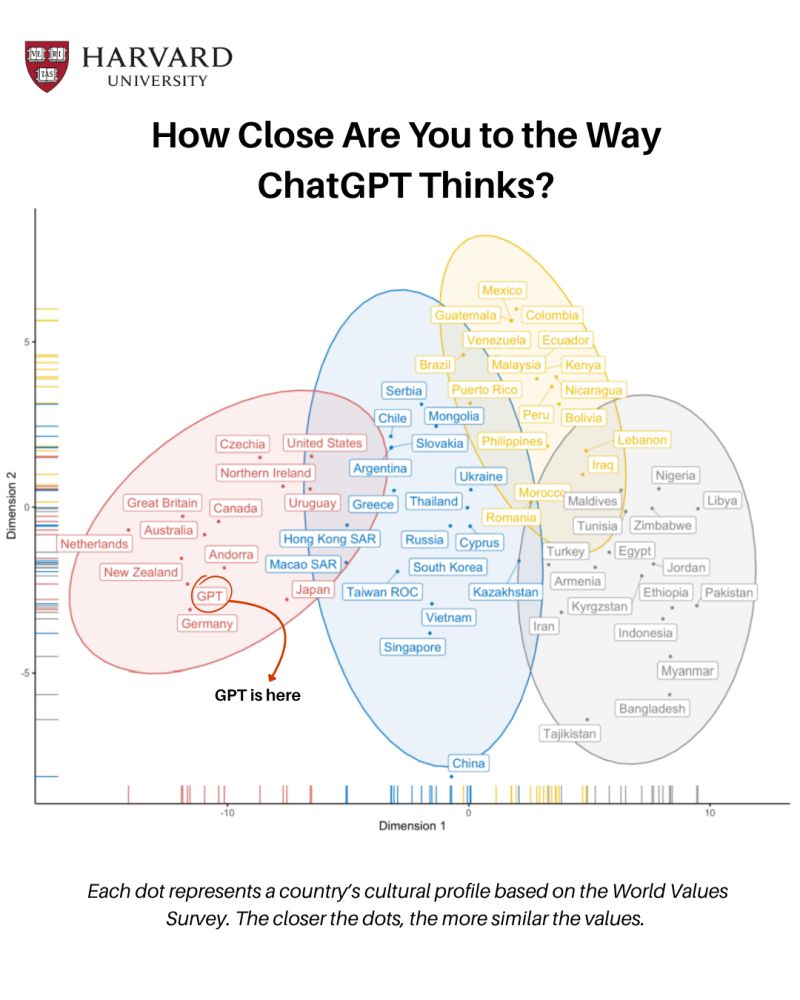

Dopo anni di dibattito sul tema, appare evidente che il futuro del lavoro non sia un orizzonte già scritto. È uno spazio di progettazione: le tecnologie evolvono rapidamente, ma la loro direzione dipende dalle scelte culturali e strategiche che sapremo compiere. Servono nuove competenze, certamente: competenze digitali avanzate, capacità di lettura dei dati, comprensione dei sistemi intelligenti. Tuttavia, prima ancora delle skill tecniche, sono necessarie innovazioni culturali. Occorre ripensare il rapporto con l’errore, con l’apprendimento continuo, con la distribuzione del potere decisionale, sviluppare quella che Donald Schön ha definito riflessività. E – mai come oggi – occorre sviluppare fiducia nei dati, ma anche senso critico verso di essi, in un mondo dominato da “ectipi” (Floridi, 2025) e da una sintesi di dati fabbricati che ci impongono di domandarci cosa sia reale e cosa non lo sia.

Rimane centrale la domanda che già animava la prima edizione: quale futuro del lavoro vogliamo contribuire a costruire? Spostare la prospettiva dalla previsione alla progettazione significa assumersi una responsabilità. Significa riconoscere che organizzazioni, leader e professionisti non sono spettatori del cambiamento, ma co-autori.

In questa nuova versione del volume ho cercato di offrire strumenti concettuali e operativi per orientarsi in uno scenario che non è solo più complesso, ma più interconnesso. Tecnologia, modelli organizzativi, cultura e impatto sociale non possono più essere trattati come ambiti separati. Comprendere, come ricordava Heisenberg, significa individuare il legame che riconduce fenomeni diversi a un insieme coerente. È in questa coerenza che si gioca la sostenibilità del lavoro futuro.

Il futuro del lavoro resta, quindi, un cantiere aperto. Non una tendenza da osservare, ma un progetto da guidare. Questa nuova edizione rappresenta un invito a farlo con maggiore consapevolezza, rigore e intenzionalità.

Per chi vorrà approfondire e continuare la discussione, il libro è disponibile online. Il confronto, come sempre, rimane aperto su questo spazio e sui miei canali: https://amzn.to/4arU0Jy