L’Intelligenza Artificiale (IA) sta trasformando rapidamente le industrie, le società e le economie. Con il progresso delle tecnologie IA, aumentano anche i rischi e le implicazioni legate al loro utilizzo. Il Rapporto Internazionale sulla Sicurezza dell’IA 2025 fornisce un’analisi approfondita delle capacità, dei rischi e delle strategie di mitigazione relative all’IA generalista. Questo post sintetizza i principali risultati del rapporto, trattando:

- Le capacità in rapida evoluzione dell’IA

- I rischi associati a usi malevoli, malfunzionamenti e sfide sistemiche

- Lo stato attuale della gestione dei rischi e delle strategie di mitigazione

- Le implicazioni più ampie per i decisori politici e le imprese

Il rapporto è frutto del contributo di 96 esperti internazionali di IA provenienti dal mondo accademico, governativo e industriale, e riflette la più recente comprensione dei rischi legati all’IA e dei meccanismi di sicurezza. È stato sviluppato nell’ambito di un’iniziativa globale per creare un approccio condiviso alla governeance e alla sicurezza dell’IA.

Capacità dell’IA Generalista

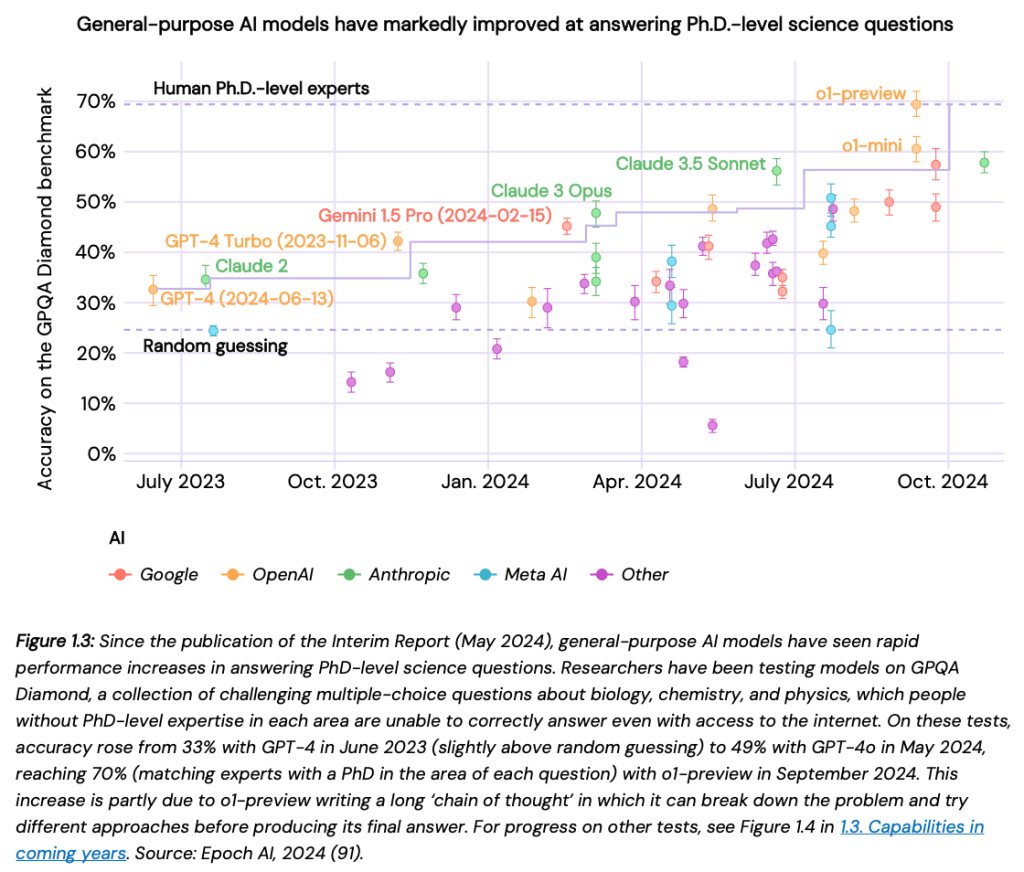

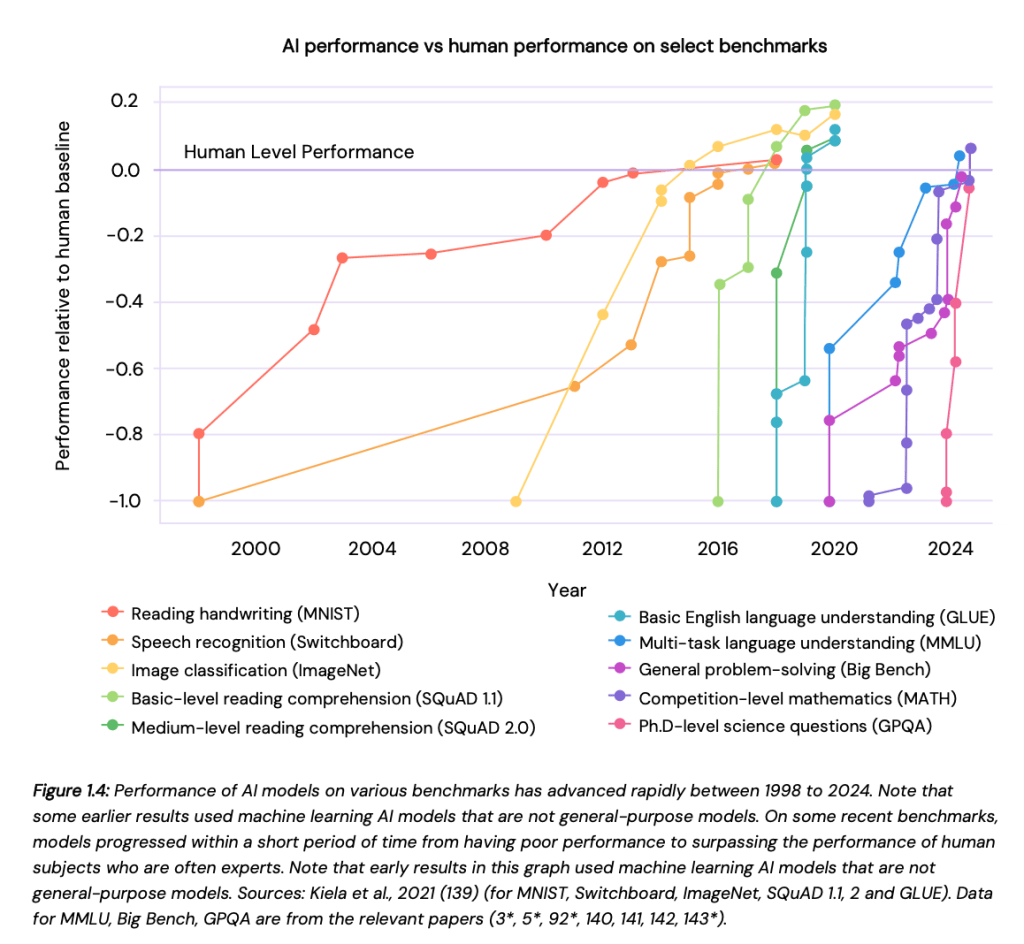

Le capacità dell’IA si sono evolute a un ritmo straordinario, superando le aspettative precedenti. Cinque anni fa, i modelli di IA faticavano a generare paragrafi coerenti. Oggi sono in grado di:

- Scrivere e correggere codice con precisione crescente, assistendo gli sviluppatori nell’automazione di compiti complessi e nell’individuazione di vulnerabilità prima del rilascio.

- Sostenere conversazioni avanzate in più lingue, con una maggiore consapevolezza del contesto, intelligenza emotiva e coerenza delle risposte, rendendoli strumenti preziosi per il servizio clienti, la terapia e la creazione di contenuti.

- Generare immagini, video e audio realistici, indistinguibili dai contenuti creati dall’uomo, aprendo nuove opportunità creative ma anche sollevando questioni etiche, specialmente nella lotta alla disinformazione e alle frodi.

- Eseguire ragionamenti scientifici e risolvere problemi matematici a livelli esperti, supportando la ricerca in fisica, chimica e medicina, accelerando la scoperta di nuovi farmaci e aiutando nella modellazione climatica.

Over 90% of online content could be AI-generated by 2030, raising concerns about authenticity, trust in media, and election security.

Rischi Associati all’IA Generalista

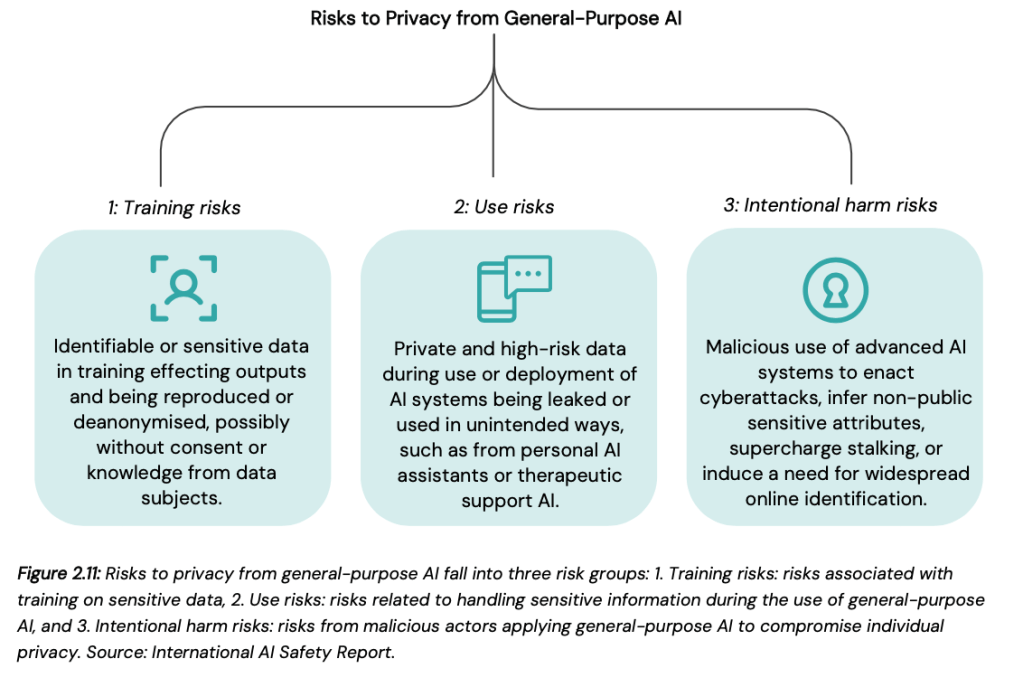

Con l’aumento delle capacità dell’IA, crescono anche le preoccupazioni sul suo potenziale utilizzo improprio e sulle conseguenze indesiderate. Il rapporto classifica i rischi dell’IA in tre categorie principali:

Rischi di Uso Malevolo

L’IA può essere sfruttata da attori malintenzionati per causare danni su larga scala. Tra le minacce più preoccupanti troviamo:

- Contenuti falsi e deepfake: I media generati dall’IA possono essere usati per diffondere disinformazione, frodi o ricatti. Alcuni studi stimano che oltre il 90% dei contenuti online potrebbe essere generato dall’IA entro il 2030, sollevando preoccupazioni su autenticità, fiducia nei media e sicurezza elettorale.

- Manipolazione dell’opinione pubblica: Le campagne di propaganda guidate dall’IA possono influenzare elezioni, decisioni politiche e movimenti sociali. Eventi passati hanno dimostrato come reti di bot e contenuti generati dall’IA siano stati usati per distorcere il discorso politico, aumentando la polarizzazione e minando la democrazia.

- Attacchi informatici: L’IA viene sempre più sfruttata nella cybersicurezza, sia per misure difensive che per forme avanzate di hacking. Strumenti di rilevamento automatico delle vulnerabilità e sfruttamento delle falle, alimentati dall’IA, potrebbero rappresentare gravi minacce alle infrastrutture digitali.

- Minacce biologiche e chimiche: Alcuni modelli di IA hanno dimostrato la capacità di assistere nella progettazione di agenti biologici dannosi, sollevando preoccupazioni sulla possibilità di un uso improprio da parte di attori non statali o organizzazioni criminali.

AI-driven automation is expected to replace millions of jobs, requiring large-scale workforce reskilling initiatives to mitigate economic displacement.

Rischi di Malfunzionamento

Anche quando non viene utilizzata in modo malevolo, l’IA può causare danni involontari a causa di difetti di progettazione, dati di addestramento incompleti o comportamenti imprevedibili. I rischi includono:

- Problemi di affidabilità: I sistemi di IA a volte generano informazioni false o fuorvianti, soprattutto in settori critici come medicina, diritto e finanza.

- Bias e discriminazione: Gli algoritmi possono amplificare e perpetuare pregiudizi presenti nei dati di addestramento, causando discriminazioni in ambiti come assunzioni, prestiti e applicazione della legge.

- Perdita di controllo: Gli esperti avvertono che i futuri sistemi di IA potrebbero diventare sempre più difficili da prevedere e gestire, sollevando interrogativi sulla necessità di garantire un allineamento sicuro tra IA e obiettivi umani.

Rischi Sistemici

Oltre ai problemi legati ai singoli modelli, l’adozione diffusa dell’IA porta a rischi più ampi per l’economia e la società:

- Disoccupazione tecnologica: L’automazione guidata dall’IA potrebbe eliminare milioni di posti di lavoro, rendendo necessarie iniziative su larga scala per la riqualificazione della forza lavoro.

- Concentrazione del potere dell’IA: Poche aziende dominano lo sviluppo dell’IA, creando squilibri nell’accesso alle tecnologie avanzate e nella capacità di regolamentare il settore.

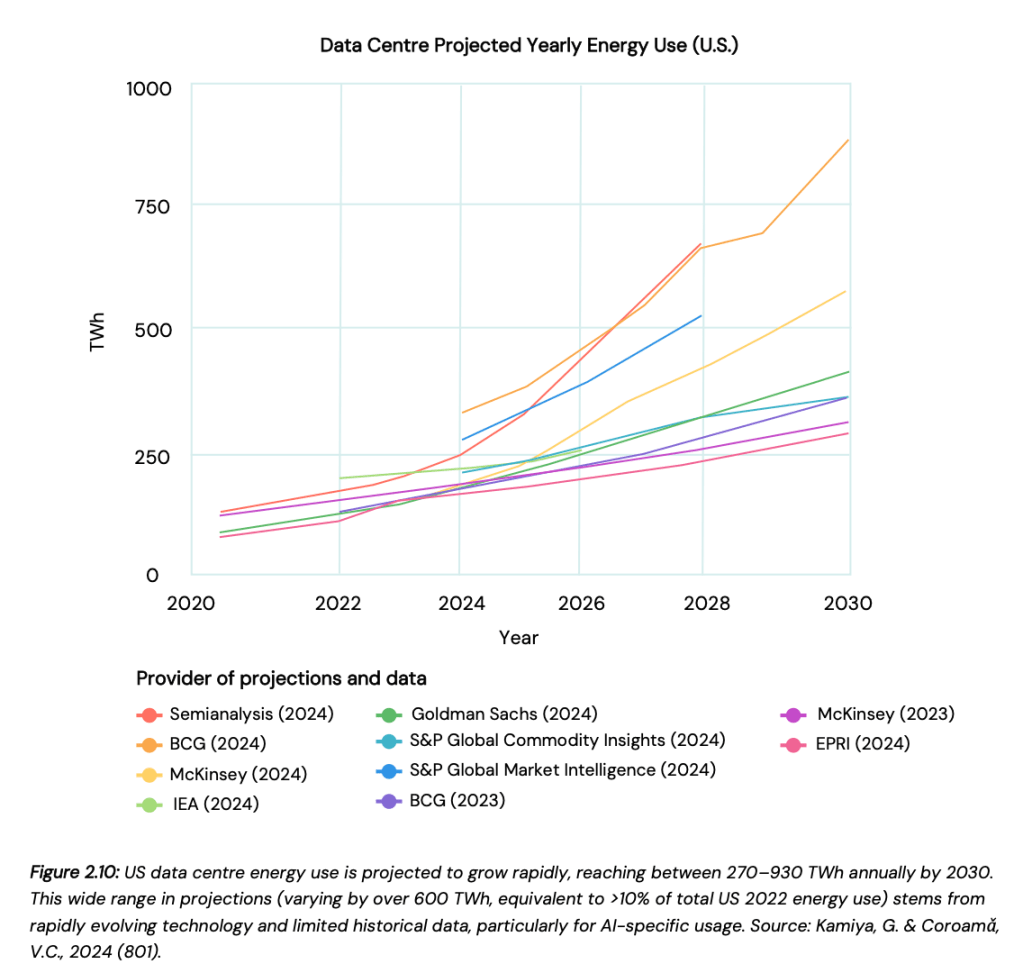

- Impatto ambientale: L’addestramento di un singolo modello di IA di grandi dimensioni può produrre tanta CO₂ quanto cinque automobili nel corso della loro vita utile.

Training a single large AI model produces as much CO₂ as five cars over their lifetime, necessitating greener computing solutions and regulatory interventions.

Gestione del Rischio e Strategie di Mitigazione

Le strategie di gestione del rischio devono concentrarsi sulla trasparenza, sulla conformità normativa e sull’etica dell’IA. Governi e imprese devono sviluppare quadri normativi completi che garantiscano un uso responsabile dell’IA, imponendo test rigorosi prima del rilascio dei modelli.

Gli investimenti nella ricerca sulla sicurezza dell’IA devono aumentare, con un focus su interpretabilità, riduzione dei bias e robustezza contro attacchi esterni. Le collaborazioni pubblico-private possono contribuire a creare organismi di vigilanza indipendenti per garantire la responsabilità nello sviluppo dell’IA.

Il Futuro dell’IA e le Considerazioni Politiche

La governance dell’IA, lo sviluppo etico e gli standard normativi saranno cruciali per definire il modo in cui l’IA verrà integrata nella società. I responsabili politici devono bilanciare innovazione e sicurezza, garantendo che l’IA sia utilizzata per il bene pubblico.

Le future politiche dovrebbero concentrarsi sulla democratizzazione dell’accesso all’IA, prevenendo il controllo monopolistico sulle tecnologie e promuovendo uno sviluppo sostenibile dell’IA per ridurre l’impatto ambientale.

AI does not happen to us; it is shaped by the choices we make today. Ensuring a future where AI serves humanity requires vigilance, cooperation, and a commitment to responsible innovation.

Il Rapporto Internazionale sulla Sicurezza dell’IA 2025 è una risorsa fondamentale per comprendere il panorama in evoluzione dell’IA. Le scelte che società e governi faranno oggi determineranno se l’IA rimarrà una forza positiva o diventerà una sfida globale.